| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

Tags

- lambda

- Class

- zgc

- g1gc

- For

- programmers

- jvm

- UserDetails

- SpringBoot Initializr

- Spring Security

- Sprint Security

- Kotlin

- 자료형

- datatype

- Java

- datastructure

- quicksort

- While

- Fluent-bit

- 연산자

- If

- JavaScript

- Algorithm

- JPA

- IAC

- ansible

- redis

- 기초

- C++

- MergeSort

Archives

- Today

- Total

뭐라도 끄적이는 BLOG

03. 회귀 문제의 이해 본문

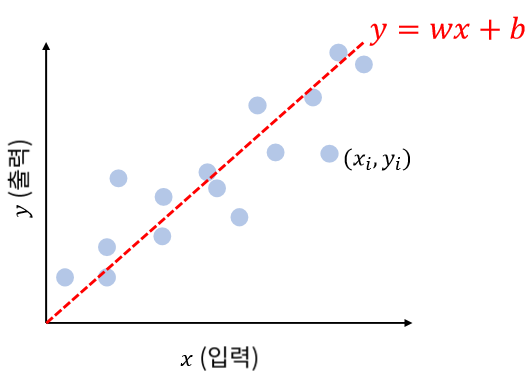

단순 선형 회귀

데이터를 가장 잘 표현하는 선형식을 찾는 동작

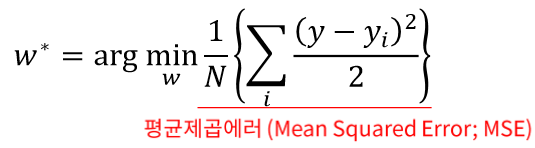

arg는 오른쪽 수식에 가장 작은 값을 가지는 w를 찾는다. 라는 의미입니다.

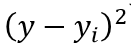

에러를 제곱한 부분입니다. 1/2이 붙는 이유는 미분시 상수값을 없애기 위한 관습입니다.

MSE를 최소로 하는 w를 찾아라

w와 b를 지정하여 추정한 선형 회귀의 값(y)과 실제 (yi)값의 오차를 제곱한 값들의 평균이 가장 낮은 점을 찾는 것이 선형회귀의 핵심입니다.

단순 선형되귀는 독립변수(입력)이 하나이므로, 추정해야 할 변수도 하나입니다. 단, bias를 포함하면 2개가 됩니다.

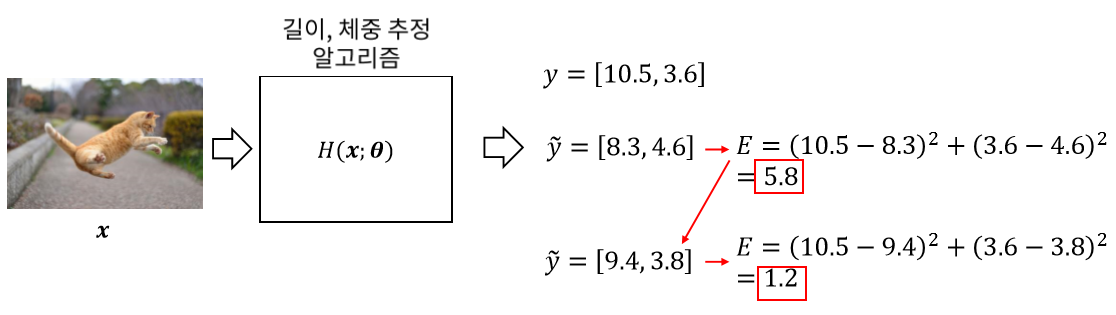

평균 제곱 오차

MSE를 이용해, 고양이의 길이와 체중의 오차를 종합적으로 판단할 수 있습니다.

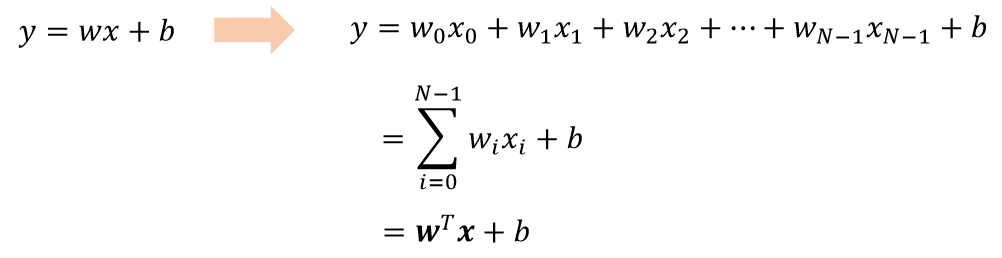

다중 선형 회귀

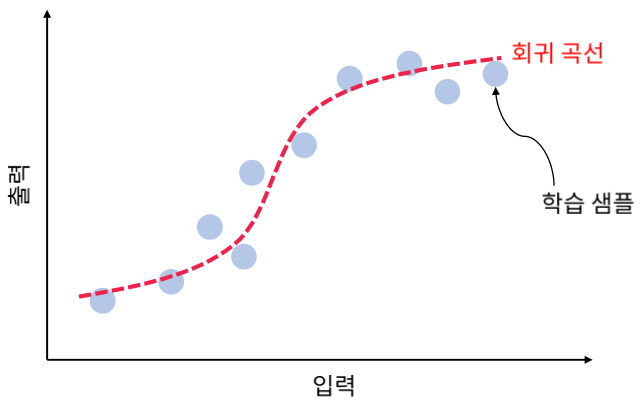

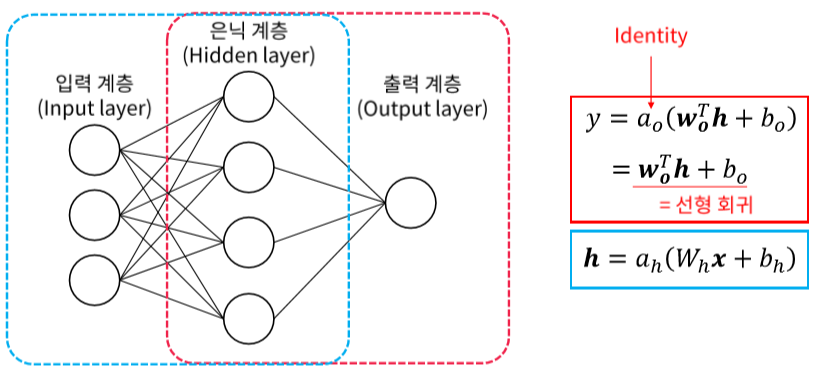

얕은 신경망과 회귀 알고리즘

얕은 신경망으로 회귀를 수행할 경우, 출력 계층은 선형 회귀와 동일하다. 입력 계층에서 은닉 계층으로 추가적인 변환이 있다는 것이 다른점입니다.

은닉계층과 회귀

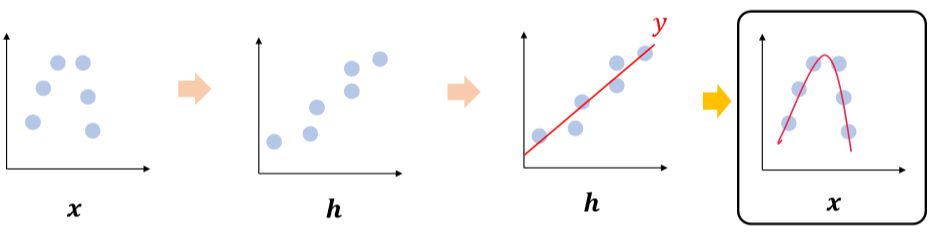

선형적으로 분포되지 않는 입력 → 선형적으로 분포하는 은닉 계층 → 선형 회귀

입력을 기준으로 보면 회귀 곡선으로 보이게 되는 선이 그어지게 됩니다.

반응형

'AI > 이론' 카테고리의 다른 글

| 05. 다중 분류 문제 (0) | 2021.05.02 |

|---|---|

| 04. 이진 분류 문제 (0) | 2021.05.02 |

| 02. 얕은 신경망의 수식적 이해 (0) | 2021.05.02 |

| 01. 얕은 신경망을 이용한 분류와 회귀 (0) | 2021.05.02 |

| 00-01 AI, Machine Learning, Deep Learning (0) | 2020.04.14 |